Der Weg zu mehr Energieeffizienz im White Space des Data Centers

Die Überwachung der Rechenzentrumsumgebung liefert den Betreibern wichtige Daten, Analysen und Informationen, die es ihnen erlauben, die Effizienz zu erhöhen, den Energieverbrauch zu senken und folglich Einsparungen zu realisieren. Modulare Lösungen zur Steigerung der thermischen Effizienz, die anhand von Temperatur- und Druckmessungen den White Space im Data Center steuern, setzen klare Zielvorgaben. So ist es den Betreibern möglich, ihre Ziele zu erreichen und potenziell kostenneutrale Systeme sowie massive laufende Einsparungen umzusetzen.

Wenn wir über den White Space im Data Center sprechen, beziehen wir uns auf den Bereich für Server, Switches und die Datenspeicherung, in dem sich auch die Lüftungsanlagen für diese Serverschränke befinden. Die anderen Bereiche des Rechenzentrums, die ebenso wichtig sind und die Kühlaggregate, USVs und übrigen Betriebseinrichtungen beherbergen, werden in diesem Zusammenhang als Grey Space bezeichnet. Die Überwachung und Steuerung sowohl der Grey Spaces als auch der White Spaces ist für eine Reihe von Konformitäts- und Kundenanforderungen unverzichtbar, beispielsweise für PUE-Ratings.

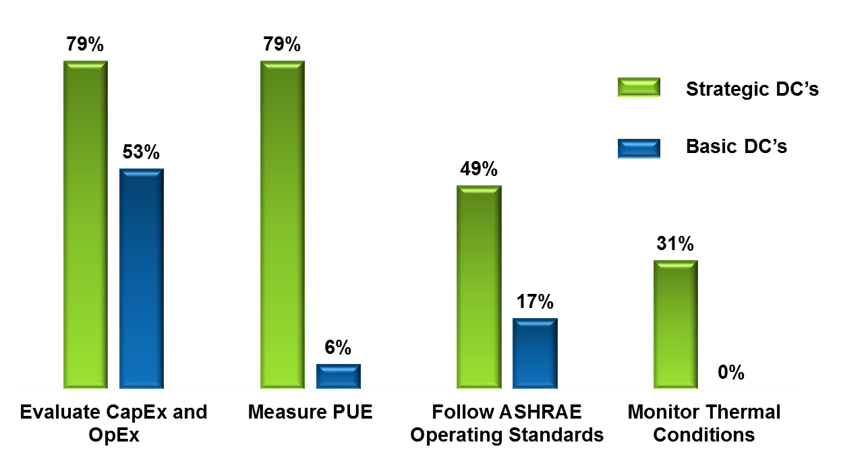

Die Anforderungen der Industrie und der Kunden veranlassen mehr und mehr Rechenzentrumsbetreiber zur Implementierung von Systemen zur Umgebungsüberwachung. Derzeit bestehen hinsichtlich der Implementierung gravierende Unterschiede zwischen „strategischen“ und „grundlegenden“ Rechenzentren. Der finanzielle und ökologische Nutzen, den der Einsatz eines intelligenten Überwachungssystems, insbesondere in modularen Asset Management- und Konnektivitäts-Management-Lösungen, mit sich bringt, ist ein überzeugendes Argument.

Bild 1. Gründe, warum Rechenzentrumsbetreiber in Umgebungsüberwachung investieren (Quelle: Schätzungen von IBM)

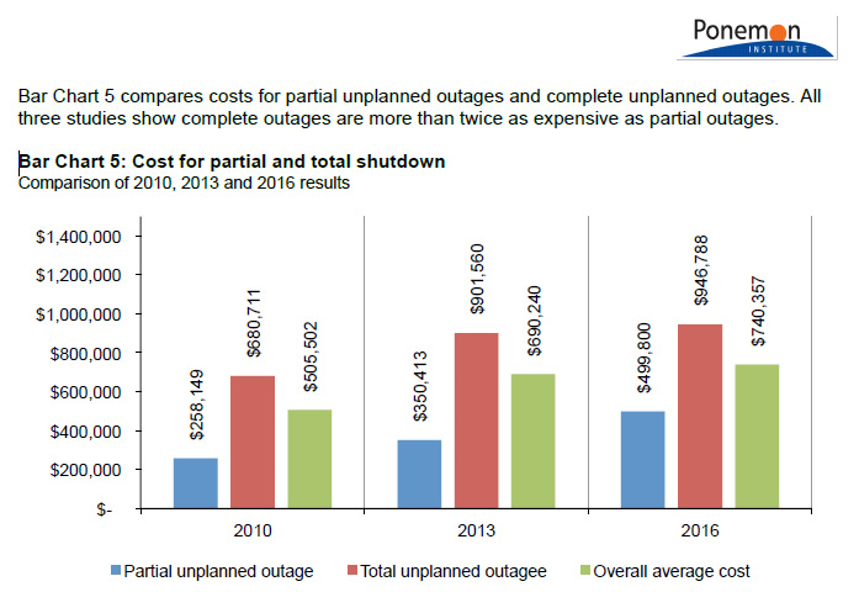

Bild 2. Kosten eines partiellen und vollständigen Ausfalls

Internationale Normen wie ASHREA TC 9.9, ETSI EN 300 und EN 50600-2-3 liefern einen Rahmen für Best Practices, Compliance und die angemessene Auslegung von IT-Umgebungen (Information Technology Environments, ITE). Die Betreiber haben zudem die nötige Technologie, um Systeme und Richtlinien basierend auf diesen Grundsätzen für Datenverarbeitungsumgebungen zu konzipieren, sodass derartige Überhitzungsvorfälle vermieden und Unterbrechungen für die Benutzer mit den möglichen finanziellen Auswirkungen reduziert oder ganz ausgeschlossen werden können.

Grundsätze für Luftstrom-Management & Kühlsystemsteuerung nach ASHREA TC 9.9

- Serverschrank-/Rack-Ebene: Die Eintrittstemperatur und relative Luftfeuchtigkeit für Racks und Serverschränke werden unten, mittig und oben im Schrank gemessen und überwacht, um einen empfohlenen Temperaturrichtwert (15 – 32°C) aufrecht zu erhalten.

- Einhausungsebene – zusätzlich zu 1.: Bei Verwendung einer Kaltgangeinhausung kann die Temperatur im Warmgang bis zu 50 °C betragen. Die Austrittstemperatur wird oben am Rack und Serverschrank gemessen und überwacht. Wenn eine Warmgangeinhausung genutzt wird, ist eine Temperaturüberwachung im gesamten Raum erforderlich.

- Data Hall-Ebene – zusätzlich zu 1. und/oder 2.: In der Nähe jedes CRAC/CRAH müssen die Luftfeuchtigkeit und Temperatur am Ein- und Austritt überwacht werden. Der Richtwert für die relative Luftfeuchtigkeit liegt bei 60% r.F. Zulässig sind Werte zwischen 20% und 80% r.F.

- Luftstrom-Management & Kühlsystem-Steuerung: Für das Luftstrom-Management und die Kühlsystemsteuerung muss eine Strategie definiert werden. Bei einem guten Luftstrom-Management kann die Temperatur auf bis zu 20°C ansteigen; bei einer Eintrittstemperatur von 40°C beträgt die Temperatur im Warmgang rund 60 °C.

Eine weitere wichtige Komponente eines effektiven Luftstrom-Management- und Kühlsystems für den White Space des Rechenzentrums ist das Luftdruckmanagement.

Rechenzentren sind sehr energieintensiv. Der Betrieb eines White Space mit mehreren Hundert oder Tausend Servern verbraucht Unmengen an Energie, was mit einer starken Wärmeentwicklung einhergeht. Dieser muss begegnet werden. Es ist nicht ungewöhnlich, dass das Kühlsystem einer solchen Einrichtung genauso viel oder sogar mehr Energie verbraucht als der White Space selbst. Ein gut konzipierter White Space mit einem überwachten und steuerbaren Kühlsystem hat heute einen deutlich geringeren Energiebedarf. Vielfach werden durch die neuesten Entwicklungen im Bereich der thermischen Planung, Überwachung und Kühlungsoptimierung Tausende von Euro, Pfund und Dollar an Energiekosten eingespart, während gleichzeitig Problemen vorgebeugt wird, sodass ein stabileres, zuverlässigeres Rechenzentrum entsteht.

Um diese wichtige Veränderung auf den Weg zu bringen, ist ein Umdenken erforderlich. Die vormals übliche Herangehensweise war, für eine kühle Umgebung zu sorgen, in der kalte Luft über die Oberflächen der heißen Geräte (Server und Switches) strömt und die warme Abluft abtransportiert wird. Diese HLK-Lösung verbraucht viel Energie, um die Temperatur der „Zuluft“ auf das nötige Maß für die Senkung der Temperatur an den heißen Geräten abzukühlen, während die heiße Abluft oft ungenutzt abgeleitet wird und verloren geht.

Trend zu alternativen Kühlmethoden im Data Center

Die heutigen Datenverarbeitungsanlagen im White Space haben höhere Betriebstemperaturen. Dies führte dazu, dass die Rechenzentrumsindustrie alternative Kühlmethoden entwickelt hat, die sich intelligente Umgebungen zu Nutze machen. Je höher die Betriebstemperatur im White Space ist, umso weniger Energie wird für den Ausgleich der „Zulufttemperatur“ benötigt. Eine Eintrittstemperatur an den Geräten zwischen 18 und 27°C und eine relative Luftfeuchtigkeit von 20 bis 80%. erfüllen im Allgemeinen die vom Hersteller angegebenen Betriebsbedingungen.

Zunehmend an Bedeutung gewinnt die Möglichkeit, den empfohlenen Bereich der Umgebungsbedingungen, einschließlich Temperatur und relativer Luftfeuchtigkeit, zu überwachen und zu steuern und die zulässigen Umgebungsbedingungen aufrecht zu erhalten, unter denen die Systeme mit optimaler Leistung arbeiten.

Der Betrieb in einer höher temperierten Umgebung bedeutet, dass Hochleistungsserver näher an die Grenzen ihrer maximalen Betriebsparameter gebracht werden. Sollte zum Beispiel eine ausgeprägte Spitze in der Prozessoraktivität auftreten und viele weitere Server in Betrieb gehen, um die benötigte Kapazität bereitzustellen, während gleichzeitig ein Generator ausfällt und die USV-Sicherung nicht zu 100 Prozent effizient läuft, kann dies zur Folge haben, dass Kühlerventilatoren nicht schnell genug anlaufen und die Server folglich überhitzen und ausfallen.

Wie bereits erwähnt, sind ungeplante Ausfälle für das Rechenzentrum vielfach mit Umsatzeinbußen verbunden, zum Beispiel aufgrund von Schadensersatzforderungen der Kunden, Reputationsschäden und verlorenen Neukundenaufträgen.

Wichtig für eine optimale Leistung ist die Fähigkeit, die thermische Umgebung des White Space intelligent zu überwachen und die generierten Daten in Echtzeit zu analysieren, um aussagekräftige Informationen für die Aufrechterhaltung eines effektiven White Space-Betriebs zu erhalten.

Rechenzentrumsbetreiber müssen drei spezifische Ebenen beachten und implementieren, um eine optimierte Lösung für die Überwachung und Kühlung der Betriebsumgebung bereitzustellen:

- Überwachung – Alarme und Meldungen: ASHREA definiert Grundsätze für die Sensoranordnung im ITE White Space. Die neueste Generation von WLAN-Sensoren bietet thermische Knoten, thermische Knoten mit Luftfeuchtigkeitsmessung und Druckknoten. Diese lassen sich mühelos in einem drahtlosen Mesh-Netzwerk konfigurieren und ermöglichen eine einfache, schnelle und sichere Bereitstellung von Geräten mit einem in hohem Maße stabilen, selbstregenerierenden, skalierbaren und effizienten Sensornetzwerk.

- Kühlungsoptimierung – Anpassung des Luftstroms und Ausgleich von Bodenunebenheiten: Der Entwurf von Luftstromkennzahlen mittels CFD erlaubt eine Modellierung möglicher Umgebungsbedingungen im Einklang mit den Zielen des Betreibers. Der Einsatz von Blindplatten, die Bewertung der Einhausungsmöglichkeiten und die Installation perforierter Bodenplatten sorgen für einen optimierten Luftdruck auf dem gesamten Weg. Mittels Software zur Abbildung der Kühlung in Echtzeit werden Heatmaps des White Space erstellt.

- HLK-Steuerung (Heizung, Lüftung, Klimatechnik) und dynamische Anpassung der Kühlung an die IT-Last: Echtzeit-Datenanalysen im gesamten System liefern aussagekräftige Informationen. Das System analysiert fortwährend die Daten, um das Luftstrom-Management zu verbessern und den Energieverbrauch zu senken. Die Echtzeitsteuerung erlaubt dem System, den optimierten Zustand mittels Luftstrom-Management aufrecht zu erhalten. Hierzu werden die Drehzahl der Ventilatoren reguliert, Druckknoten für das Ablesen von Messwerten verwendet und die Lufttemperatur durch eine Anpassung des Temperatursollwerts per Temperaturüberwachung gesteuert.

Schlussfolgerung

Schätzungen zufolge wird sich die zum Kühlen der weltweiten Rechenzentren benötigte Energie in den kommenden zehn Jahren verdreifachen – mit Auswirkungen auf die Kosten und die Umwelt. Kunden, Umweltorganisationen und Regierungen drängen die Industrie deshalb zu einem effizienteren Umgang mit Energie.

Rechenzentrumsbetreiber untersuchen und implementieren derzeit intelligente Systeme, um den Weg für eine fortlaufende Datenanalyse und dynamische Optimierung zu ebnen. Die für diese speziellen Anforderungen der Rechenzentrumsbetreiber konzipierten Umgebungs- und Kühlungsmanagementsysteme der neuesten Generation liefern aussagekräftige Informationen, die durch eine effizientere Anlagenauslastung auf einfache Weise einen deutlich reduzierten ROI-Zeithorizont ermöglichen.

Michael Akinla, TSE Manager EMEA, Panduit Europe